软件介绍

Ollama 是一款专为简化本地大语言模型运行而设计的开源工具,适合开发者、研究人员和爱好者使用。它支持多种开源模型,如 DeepSeek R1、Llama3 等,帮助用户在本地快速实验和管理模型。无论是部署还是调试,Ollama 都提供了便捷的解决方案,极大降低了使用门槛。

Ollama 是什么?

Ollama 是一个开源工具,专门用于在本地运行和管理大型语言模型。它让开发者、研究人员和爱好者能够轻松实验和部署各种大语言模型,比如 DeepSeek R1、Qwen2、Llama3 等。通过简单的操作,用户可以在本地环境中快速上手,无需复杂的配置。

Ollama for Mac 版本:点击下载

Ollama 和 Llama 有什么联系?

Llama 是 Meta 公司推出的一款广受欢迎的大语言模型,和其他模型一样,它可以通过 Ollama 进行管理和部署。虽然名字相似,但 Ollama 是一个通用的管理工具,而 Llama 只是它支持的众多模型之一。

简单来说,Llama 是模型,Ollama 是管理模型的工具,名字相似纯属巧合!

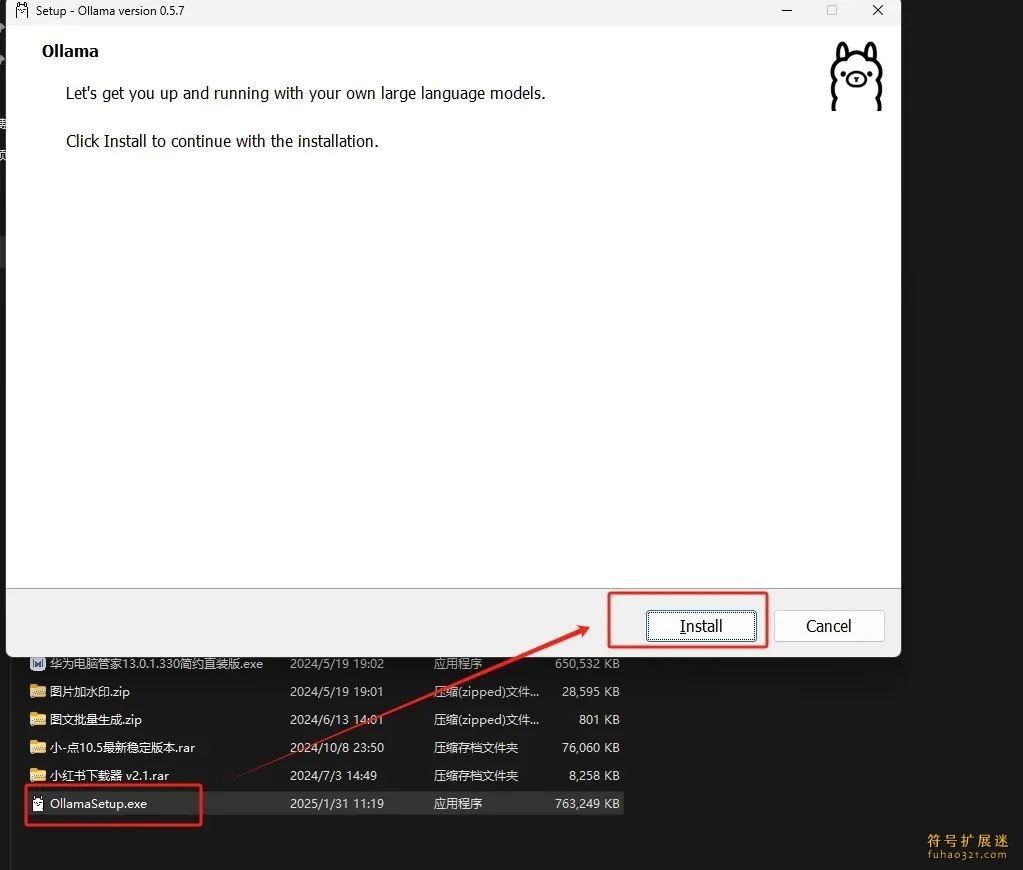

Ollama 的安装与系统设置

安装 Ollama 就像安装普通软件一样简单,只需几步就能完成。

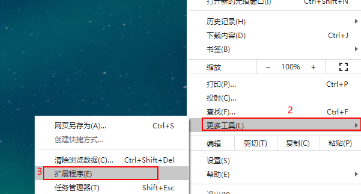

安装完成后,建议设置以下系统环境变量:

OLLAMA_MODELS:模型文件的存储路径,默认在用户目录下。如果使用 Windows 系统,建议修改为其他盘符,比如 D:\OllamaModels,避免占用 C 盘空间。

OLLAMA_HOST:设置服务监听的网络地址,默认是 127.0.0.1。如果需要让局域网内的其他设备访问,可以改为 0.0.0.0。

OLLAMA_PORT:服务监听的端口号,默认是 11434。如果端口冲突,可以改成其他端口,比如 8080。

OLLAMA_ORIGINS:HTTP 请求的来源地址,本地使用时可以设置为星号,表示不限制。

OLLAMA_KEEP_ALIVE:模型在内存中的存活时间,默认是 5 分钟。可以设置为 24h,让模型在内存中保持更长时间,提升访问速度。

OLLAMA_NUM_PARALLEL:请求的并发处理数量,默认是 1。可以根据需求调整。

OLLAMA_MAX_QUEUE:请求队列的最大长度,默认是 512。超过长度的请求会被丢弃。

OLLAMA_DEBUG:调试模式,设置为 1 时可以输出详细日志,方便排查问题。

OLLAMA_MAX_LOADED_MODELS:内存中同时加载的模型数量,默认是 1。

CPU 适配版本:

没有 GPU:1.5B Q8 推理或 8B Q4 推理

4G GPU:8B Q4 推理

8G GPU:32B Q4 推理或 8B Q4 推理

16G GPU:32B Q4 推理或 32B Q8 推理

24G GPU:32B Q8 推理或 70B Q2 推理

根据自己的硬件配置选择合适的版本。

DeepSeek R1 的本地部署方法

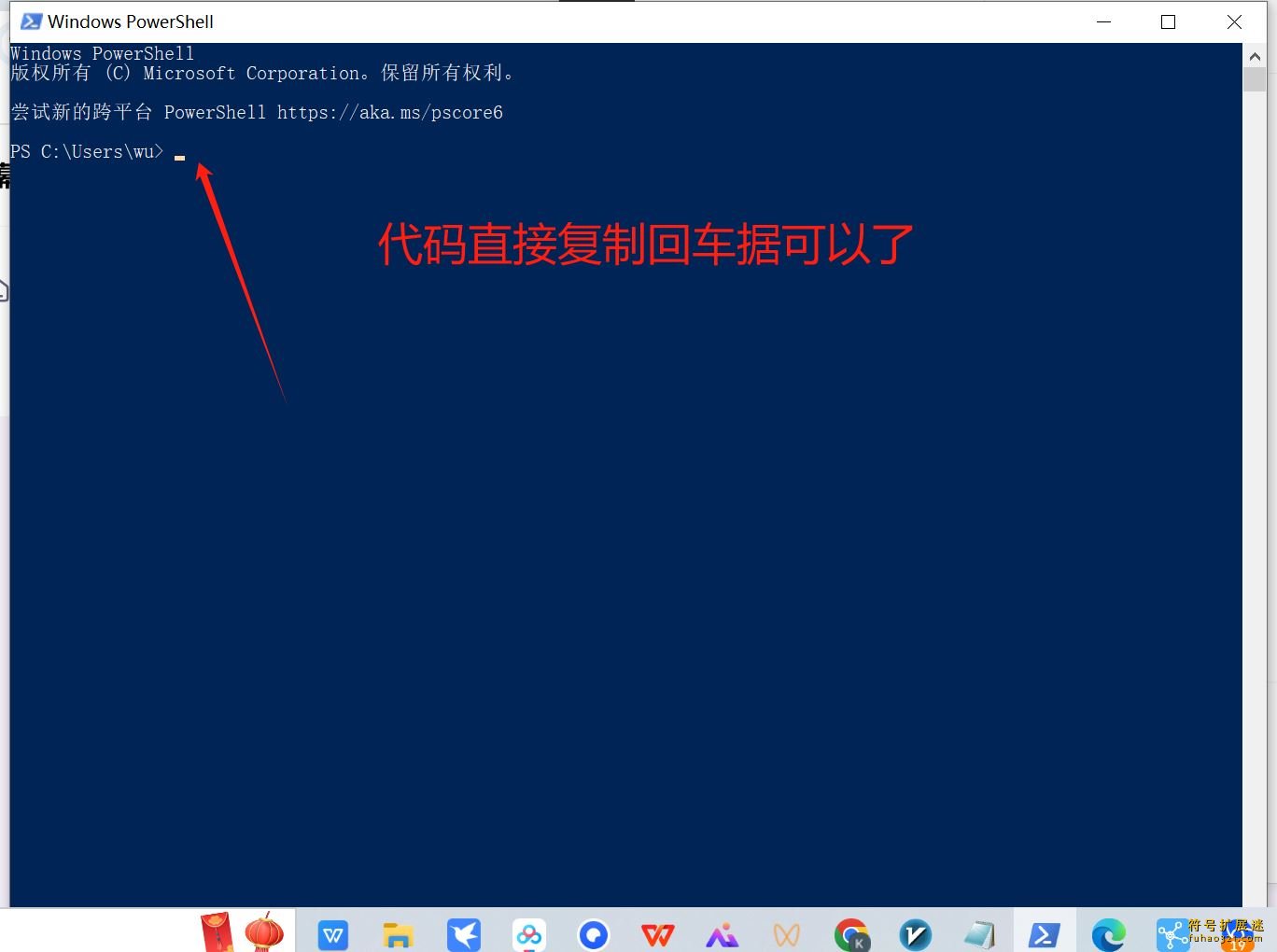

安装命令:

1.5B Qwen DeepSeek R1

安装命令:ollama run deepseek-r1:1.5b

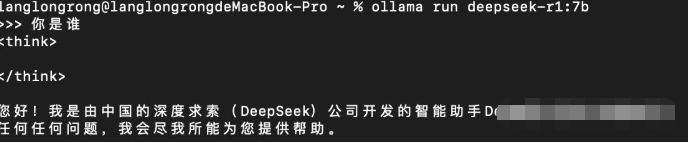

7B Qwen DeepSeek R1

安装命令:ollama run deepseek-r1:7b

8B Llama DeepSeek R1

安装命令:ollama run deepseek-r1:8b

14B Qwen DeepSeek R1

安装命令:ollama run deepseek-r1:14b

32B Qwen DeepSeek R1

安装命令:ollama run deepseek-r1:32b

70B Llama DeepSeek R1

安装命令:ollama run deepseek-r1:70b

如果遇到 403 错误,可以尝试以管理员身份运行。下载模型可能需要一些时间,完成后会看到成功界面。

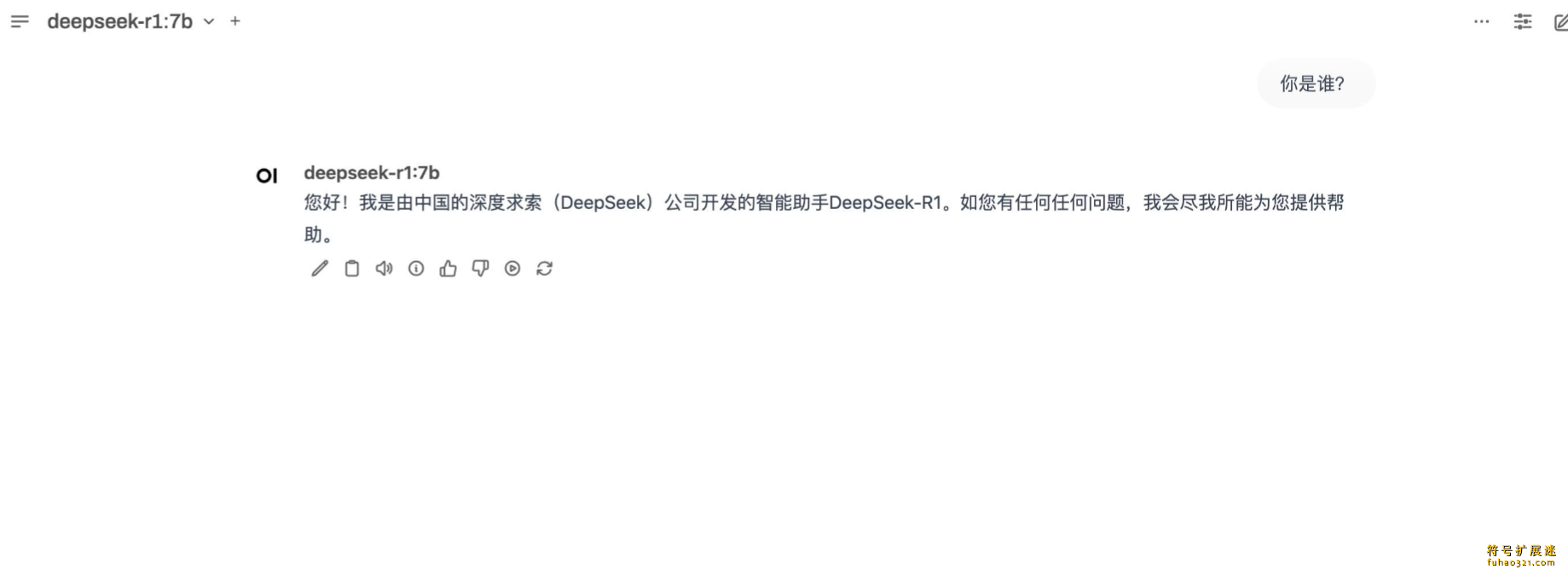

搭建 Web UI 实现网页对话

命令行操作虽然强大,但不够直观。为了更好地管理聊天内容,类似 ChatGPT 的网页对话功能非常实用。

这里推荐使用 Open Web UI,效果如下:

在搭建之前,需要先安装 Docker。安装完成后,打开 Docker 并登录,然后在终端输入以下命令:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

启动 Docker 容器后,会看到欢迎页面,点击即可开始使用。

其他 Open WebUI 工具

除了 Open Web UI,还有其他几种方式可以实现可视化交互:

1. 使用 Docker Desktop,支持一键部署大多数 GitHub 开源项目,无需额外配置环境。

2. 自行安装 Python 环境,通过 Pip 安装相关工具。

3. 直接使用浏览器插件,无需安装 Docker 或 Python。

本地部署 DeepSeek-R1 并联网:超简单的离线部署教程

4. 还可以使用 ChatBox 或 Cherry Studio 等桌面客户端。

解决 DeepSeek 服务器繁忙问题:Cherry Studio & DeepSeek 告别卡顿

Trae下载

Trae下载 蓝鲸隐私保护下载

蓝鲸隐私保护下载 17119工具箱下载

17119工具箱下载 CodeAsk下载

CodeAsk下载 DVD Flick下载

DVD Flick下载 LeafView下载

LeafView下载 纳米AI客户端下载

纳米AI客户端下载 TIA Portal V20

TIA Portal V20 证件照换服装

证件照换服装

贝锐洋葱头

贝锐洋葱头 DS CATIA P3 V5-6R2022

DS CATIA P3 V5-6R2022

W清理优化助手

W清理优化助手 影智多开

影智多开 Widgets

Widgets

用户评论