软件介绍

ONNX Runtime 是一个专注于提升机器学习推理和训练效率的工具,支持多种深度学习框架和硬件加速器。它通过优化技术和跨平台兼容性,为开发者提供高效的模型部署和运行环境。

核心功能

ONNX Runtime 能够处理从 PyTorch、TensorFlow/Keras 等框架导出的模型,同时也兼容 scikit-learn、LightGBM、XGBoost 等经典机器学习库。通过 GPU、TPU 等硬件加速器和图优化技术,它显著提升了推理性能。

无论是不同的硬件、驱动程序还是操作系统,ONNX Runtime 都能无缝兼容。它通过硬件加速和图形优化,确保模型在多种环境下都能高效运行。对于 Transformer 模型,只需在 PyTorch 训练脚本中添加一行代码,即可在多节点 NVIDIA GPU 上加速训练。

主要特点

1.跨平台支持:ONNX Runtime 支持 Windows、Linux、macOS、Android 和 iOS 等多个操作系统,特别针对基于 ARMv7 架构的 Linux 系统进行了优化。

2.优化性能:通过 GPU 和 TPU 等硬件加速器,ONNX Runtime 在多个平台上实现了显著的性能提升。

3.易于部署:它提供了一种轻量级且高效的运行时环境,让模型在生产环境中以最小的资源开销运行。

4.广泛兼容:支持 ONNX 格式,能够运行由 TensorFlow、PyTorch、Caffe2 等主流深度学习框架导出的模型。

特性

内置优化技术,可将推理速度提升高达 17 倍,训练速度提升高达 1.4 倍。

支持多种框架、操作系统和硬件平台。

在 Office 365、Visual Studio 和 Bing 中广泛应用,每天处理半万亿次推理。

ONNX Runtime 推理的示例用例

提升各种机器学习模型的推理性能。

在不同硬件和操作系统上运行模型。

在 Python 中训练模型,但部署到 C#、C++ 或 Java 应用程序中。

使用不同框架创建的模型进行训练和推理。

快速启动

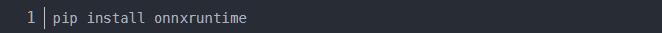

安装 ONNX Runtime

你可以通过 pip 安装 ONNX Runtime:

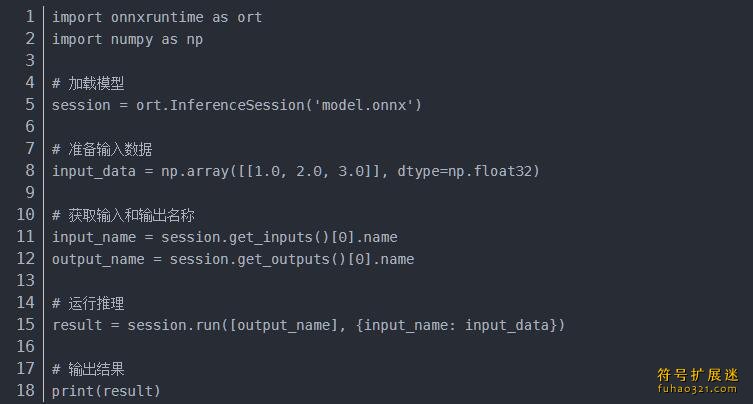

加载和运行模型

以下是一个简单的示例,展示如何加载一个预训练的 ONNX 模型并进行推理:

ONNX Runtime 支持编程语言

C++:ONNX Runtime 原生使用 C++ 编写,适合对性能要求高的应用。

Python:Python API 允许加载 ONNX 模型,支持在 CPU 和 GPU 上运行,是最常用的语言。

C#:C# API 让 .NET 开发者能够轻松集成和使用 ONNX 模型。

JavaScript:JavaScript 库支持在浏览器和 Node.js 环境中运行 ONNX 模型,便于在 Web 应用中部署机器学习模型。

此外,还支持 Java、WinRT、Objective-C、Ruby、Julia 等多种语言,覆盖范围广泛。

问小白下载

问小白下载 FMatPix下载

FMatPix下载 红枫云盘下载

红枫云盘下载 LiblibAI哩布哩布AI下载

LiblibAI哩布哩布AI下载 CyberLink ColorDirector Ultra 2024下载

CyberLink ColorDirector Ultra 2024下载 招商随行下载

招商随行下载 闪电藤下载

闪电藤下载 AIMIX智剪

AIMIX智剪

金舟驱动大师

金舟驱动大师

Class Widgets

Class Widgets 墨阕开发者工具箱

墨阕开发者工具箱 金舟光盘刻录大师

金舟光盘刻录大师 Caption Cat

Caption Cat

用户评论