软件介绍

LM Studio是一款专为本地大语言模型交互设计的桌面应用,提供高效、创新的解决方案。基于llama.cpp开发,它通过图形界面简化操作,无需命令行,专注于提升桌面端用户体验。

LM Studio是什么?

LM Studio是一个专注于本地大语言模型运行和下载的人工智能平台。它支持多种先进模型,如LLaMa、MPT和Gemma,具备强大的离线运行能力。用户可以在本地设备上高效运行模型,避免数据隐私问题和网络延迟。

软件特色

模型管理:支持从Hugging Face等资源库拉取、存储和运行GGUF格式模型,用户可以轻松浏览、搜索和选择所需模型。

硬件协同优化:基于llama.cpp架构,针对NVIDIA GPU使用GPU卸载技术,合理分配运算任务,突破显存限制。通过模型量化降低内存占用,确保在有限内存下也能平稳运行大型模型。

参数调控:用户可灵活调整“温度”“重复惩罚”等参数,精准定制模型输出。“温度”参数控制文本灵活性,“重复惩罚”参数调节文本多样性。

文本嵌入强化检索:通过POST/v1/embeddings端点生成文本嵌入向量,融入检索增强生成(RAG)架构,在海量文档和知识库搜索中表现优异。

内置兼容OpenAI的本地服务器功能:无缝衔接基于OpenAI API的应用与本地模型,大幅缩短开发适配周期,助力创新应用快速落地。

使用教程

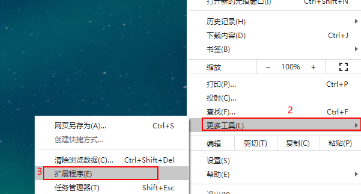

1、打开LM Studio程序。

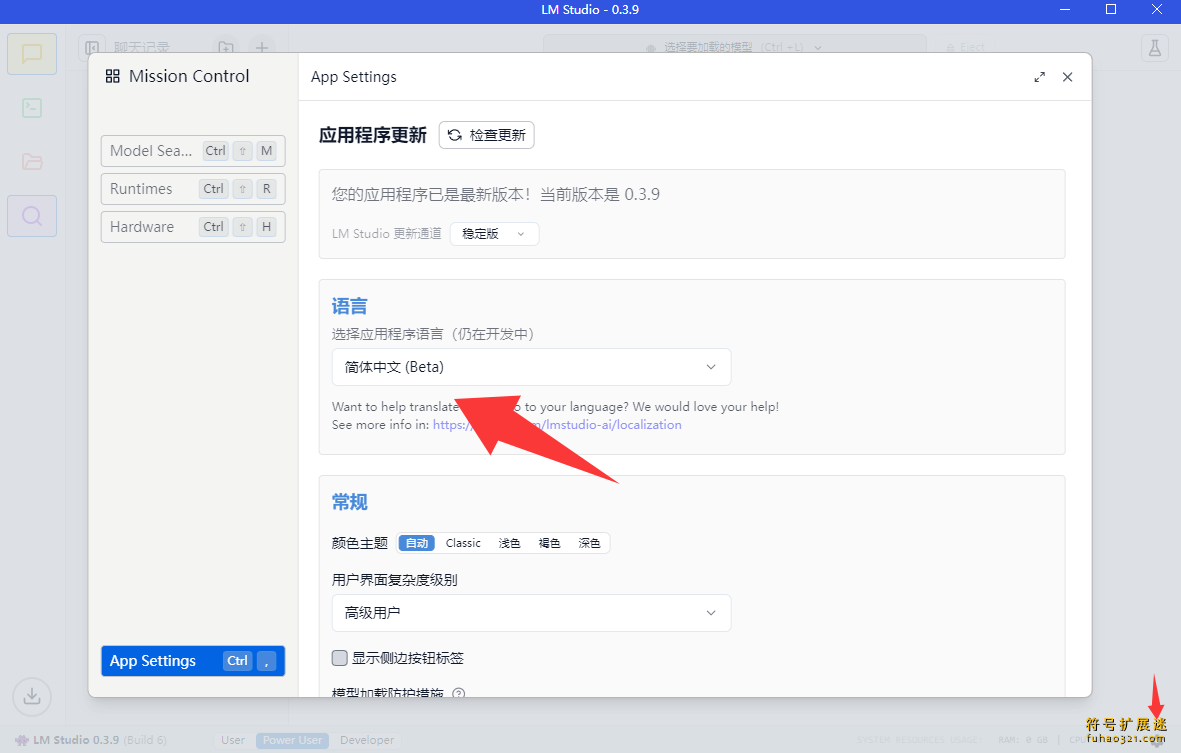

2、点击右下角的设置,将语言切换为“简体中文”。

模型存放及部署设置

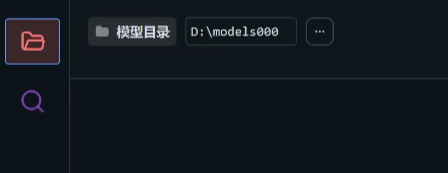

1、下载Deepseek-R1模型文件,注意文件存放位置。在客户端中选择“模型目录”,点击“更改”。

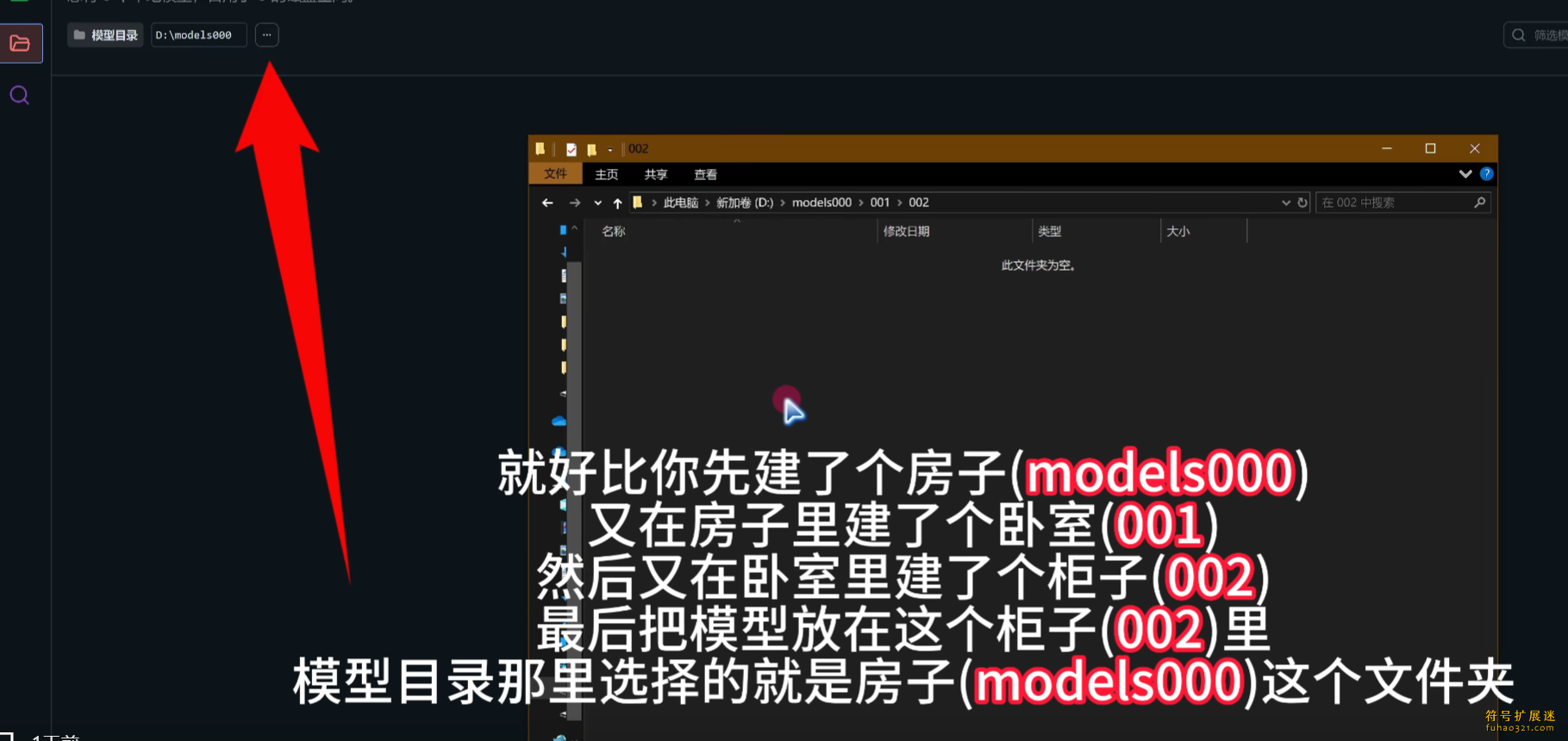

2、在D盘新建一个文件夹,命名为models000,注意文件夹名称不能包含符号或中文。

3、在models000下新建文件夹001,再在001下新建文件夹002,将下载的R1模型文件复制到002文件夹中。

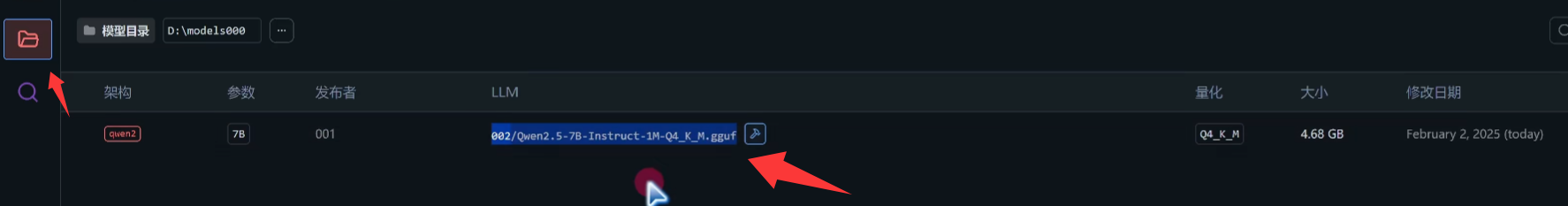

4、返回LM Studio的模型目录,即可看到已复制的模型。

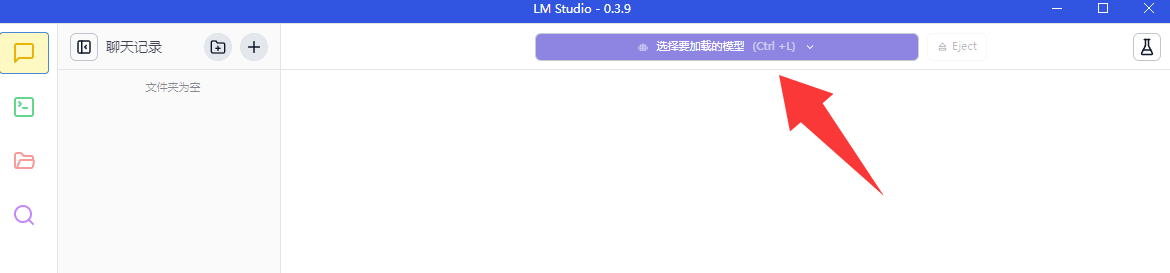

5、点击聊天界面,选择模型加载按钮。

6、选择模型后点击加载,等待完成。注意:可选择启用“快速注意力”功能。

更新日志

LM Studio 0.3.9

新增空闲TTL功能,支持Hugging Face存储库中的嵌套文件夹,以及实验性API,用于在聊天完成响应的单独字段中接收reasoning_content。

早期版本在流式处理DeepSeek R1聊天完成响应时存在错误,建议更新到最新版本(5)以修复问题。

空闲TTL和自动移出

用例:假设您使用Zed、Cline或Continue.dev等应用与LM Studio提供的LLM交互。这些应用利用JIT在首次使用模型时按需加载模型。

问题:当您未主动使用模型时,可能不希望其继续占用内存。

解决方案:为通过API请求加载的模型设置TTL。每次模型收到请求时,空闲计时器会重置。如果模型未执行任务,则认为其处于空闲状态。当空闲TTL过期时,模型会自动从内存中卸载。

您可以在请求负载中设置以秒为单位的TTL,或通过命令行使用lms load --ttl 。

在文档中阅读更多内容:TTL和自动驱逐。

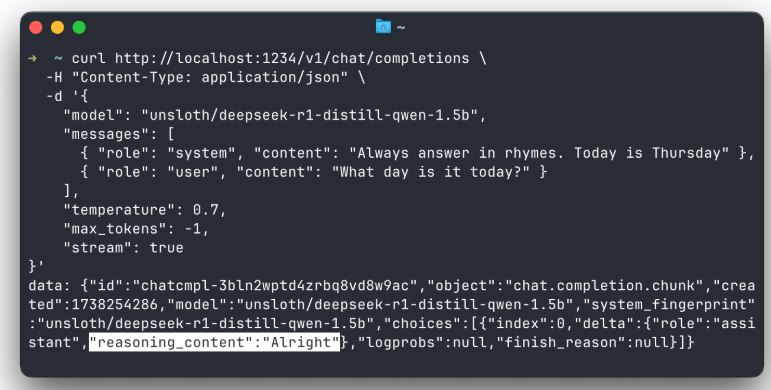

在聊天完成响应中分离reasoning_content

对于DeepSeek R1,可在单独字段中获取推理内容。DeepSeek R1模型在标签内生成内容,此内容为模型的“推理”过程。在聊天完成响应中,您现在可以在名为reasoning_content的单独字段中接收此内容。

此功能适用于流式和非流式完成,可在App Settings > Developer中启用。目前处于试验阶段。

注意:根据DeepSeek文档,不应在下一个请求中将推理内容传回模型。

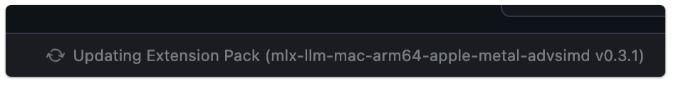

LM运行时的自动更新

LM Studio支持多种引擎变体(仅CPU、CUDA、Vulkan、ROCm、Metal)以及Apple MLX引擎。这些引擎会频繁更新,尤其是在发布新模型时。

为减少手动更新需求,引入了运行时自动更新功能。默认启用,可在App Settings中关闭。

更新运行时后,您将看到显示发行说明的通知。您也可在runtimes选项卡中自行管理:Windows/Linux上按Ctrl + Shift + R,macOS上按Cmd + Shift + R。

LM运行时会自动更新到最新版本,您可在设置中关闭此功能。

支持Hugging Face存储库中的嵌套文件夹

新增功能:您现在可以从Hugging Face存储库的嵌套文件夹中下载模型。如果模型发布者将模型组织在子文件夹中,您可直接在LM Studio中下载。

这使得下载https://huggingface.co/unsloth/DeepSeek-R1-GGUF等模型更加便捷。也适用于lms get 。

# Warning: this is a very large model

lms get https://huggingface.co/unsloth/DeepSeek-R1-GGUF

0.3.9 - 完整更改日志

版本 6

修复了在包含图像的聊天中使用纯文本模型时出现的“无法读取undefined的属性”。修复了Windows上的路径解析问题,该问题导致某些计算机上的LM运行时意外运行。修复了CUDA模型加载崩溃,“llm_engine_cuda.node.系统无法访问该文件”。修复了ROCm乱码模型生成。修复了使用旧版本应用程序创建的聊天中的RAG消息不显示的错误。修复了输入法编辑器(IME)错误:现在,按Enter键时,除非完成合成,否则不会发送消息。

构建 5

修复了在流式传输DeepSeek R1聊天完成响应时不遵循设置的API错误reasoning_content。

版本 4

新增实验性API:在聊天完成响应(流式和非流式)中的单独字段中发送reasoning_content。适用于在标签内生成内容的模型(如DeepSeek R1)。可在App Settings > Developer中启用。

构建 3

新增聊天外观选项,自动扩展新添加的Thinking UI块。新增当应用程序提供insufficient system resources错误通知时,显示对护栏配置的快速访问。修复了如果删除非默认models目录,则不会为新模型编制索引的错误。修复了硬件检测中的一个错误,该错误在使用Vulkan后端时有时会错误地过滤掉多GPU设置中的GPU。修复了模型加载UI中的一个错误,该错误导致没有Flash注意的F32缓存类型无法被识别为llama.cpp Metal运行时的有效配置。

构建 2

新增对从Hugging Face存储库中的嵌套文件夹下载模型的支持。改进了对直接使用Hugging Face URL进行搜索的支持。新增自动更新选定的运行时扩展包(您可在设置中关闭此功能)。新增使用LM Studio的Hugging Face代理的选项,帮助无法直接访问Hugging Face的用户。新增MLX模型的KV缓存量化(需要mlx-engine/0.3.0)。我的模型选项卡刷新:更整洁的模型名称和模型类型的侧边栏类别。可切换回在“应用程序设置”>“常规”中显示完整文件名。要查看原始模型元数据(以前为:(i)按钮),请右键单击模型名称,选择“查看原始元数据”。修复了清除Sampling Settings中的Top K会触发错误的bug。

版本 1

新增TTL功能:可选择在一定时间后自动卸载未使用的API模型(请求有效负载中的字段ttl)。对于命令行使用:lms load --ttl 。API参考:https://lmstudio.ai/docs/api/ttl-and-auto-evict。新增自动驱逐功能:可选择在加载新API模型之前自动卸载之前加载的API模型(在应用程序设置中控制)。修复了模型思维块内的方程式有时会在块下方生成空白空间的错误。修复了Toast通知中的文本不可滚动的问题。修复了取消选中和选中Structured Output JSON会使架构值消失的错误。修复了生成时自动滚动有时不允许向上滚动的错误。[开发商]将日志记录选项移动到Developer Logs面板标题(•••菜单)。修复了聊天外观字体大小选项在思考区块中不缩放文本的问题。

问小白下载

问小白下载 神奇音视频自动下载软件

神奇音视频自动下载软件 芝麻录屏

芝麻录屏

ztasker

ztasker AIArty Image Matting

AIArty Image Matting Cherry Studio

Cherry Studio

棱光PDF

棱光PDF HttpCanary黄鸟抓包

HttpCanary黄鸟抓包

用户评论